仅需一万块钱!清华团队靠强化学习让7B模子数学击败GPT-4o

PRIME团队 投稿

量子位 | 公众号 QbiAIOpenAI o1和o3模子的发布确认了强化学习卤莽让大模子领有像东谈主雷同的快速迭代试错、深度念念考的高阶推聪敏商,在基于效法学习的Scaling Law缓缓受到质疑的今天,基于探索的强化学习有望带来新的Scaling Law。

近日,清华大学NLP实验室、上海AI Lab、清华大学电子系、OpenBMB社区等团队提倡一种新的趋附过程奖励的强化学习关节——PRIME(Process Reinforcement through IMplicit REwards)。

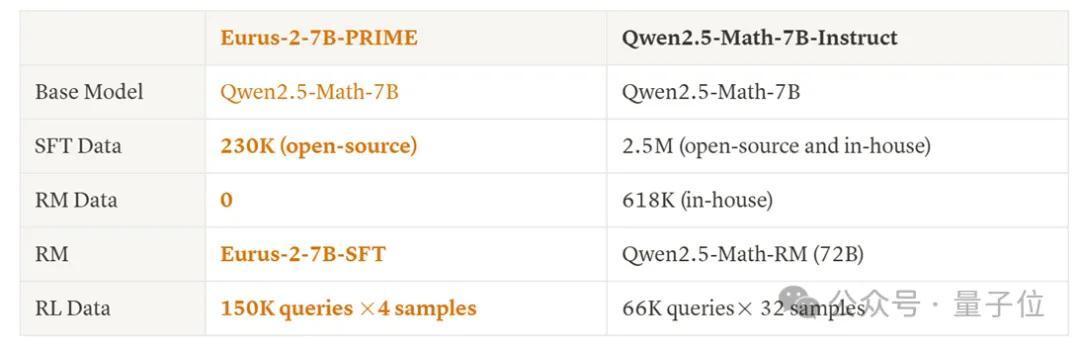

收受PRIME关节,盘考东谈主员不依赖任何蒸馏数据和效法学习,仅用8张A100,破耗一万块钱傍边,不到10天时辰,就能高效熟谙出一个数学智商高出 GPT-4o、Llama-3.1-70B的7B模子 Eurus-2-7B-PRIME。

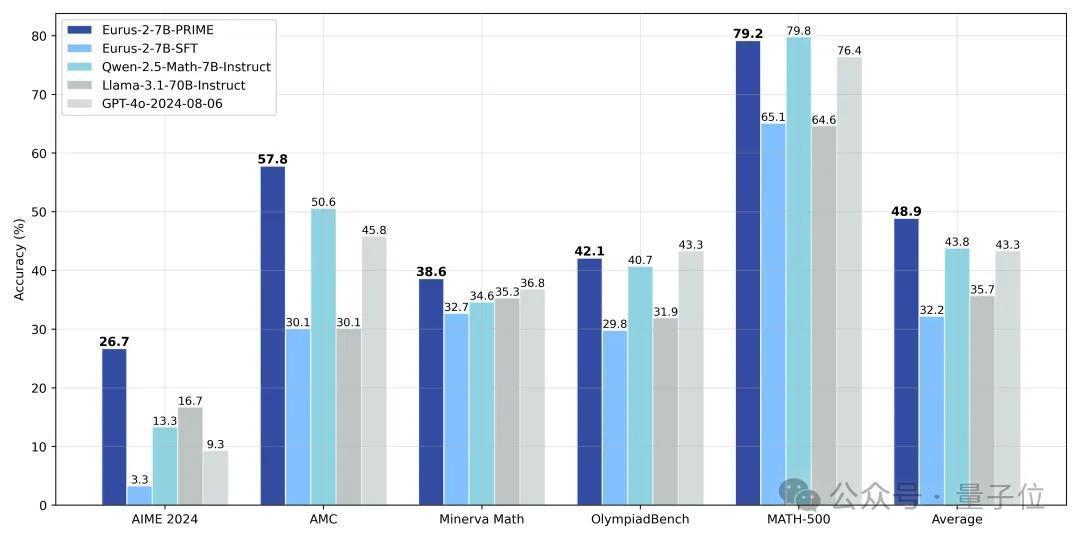

具体而言,盘考东谈主员哄骗Qwen2.5-Math-7B-Base行动基座模子,熟谙出了新模子Eurus-2-7B-PRIME,并在好意思国IMO采用熟谙AIME 2024上的准确率达到26.7%,大幅特出GPT-4o,Llama3.1-70B和Qwen2.5-Math-7B-Instruct,且仅使用了Qwen Math数据的 1/10。其中,强化学习关节PRIME为模子带来了16.7%的全王人栽种,远超已知的任何开源决策。

该名堂还是开源就在国外AI社区爆火,短短几天Github取得近300star。

改日,基于PRIME关节和更强的基座模子有后劲熟谙出接近OpenAI o1的模子。

PRIME关节先容始终以来,开源社区严重依赖数据驱动的效法学习来增强模子推聪敏商,但这种关节的局限也可想而知——更强的推聪敏商需要更高质料的数据,但高质料数据老是稀缺,使得效法和蒸馏难以捏续。

天然OpenAI o1和o3的告捷确认了强化学习有着更高的上限,但强化学习有着两个毛病挑战:(1)如何获取精确且可膨胀的密集奖励;(2)如何盘算不错充分哄骗这些奖励的强化学习算法。

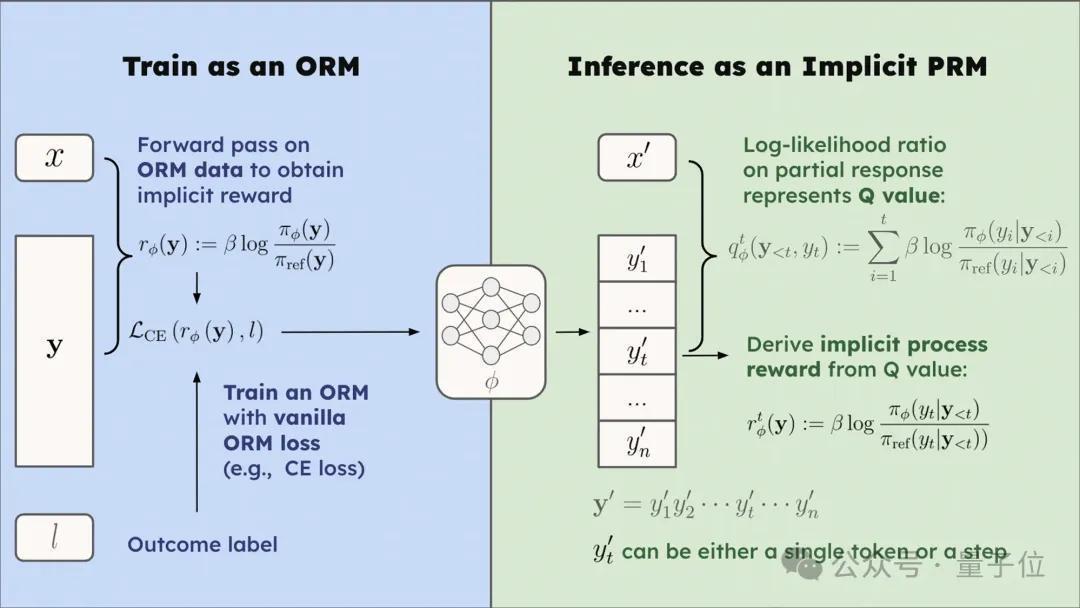

PRIME算法从隐式过程奖励(implicit process reward)的念念想登程科罚这两个问题。隐式过程奖励模子不错仅在输出奖励模子(outcome reward model, ORM)的数据,即谜底的最终对错上进行熟谙,而隐式地建模过程奖励,最终自动熟谙出一个过程奖励模子,这所有这个词过程王人有严格的表面保证。

注释推导见:https://huggingface.co/papers/2412.01981

基于隐式过程奖励模子的这种性质,盘考东谈主员指出将其应用于强化学习有三大上风:

过程奖励:隐式过程奖励模子卤莽为每个 token 提供价值估量,在提供过程奖励的同期无需熟谙尽头的价值模子(value model)可膨胀性:隐式过程奖励模子只需完好意思标签即可在线更新。是以,咱们不错趋附战略模子采样与完好意思考据器来径直更新PRM,灵验缓解漫衍偏移与可膨胀性问题。简易性:隐式过程奖励模子现实上等于一种话语模子。在履行中,盘考东谈主员发现不错径直用运行的战略模子运行化PRM。隐式过程奖励科罚了PRM在大模子强化学习中若何用,若何训,若何膨胀的三大问题,以至不需要熟谙尽头的奖励模子就不错登程点强化学习,易用性和可膨胀性极佳。

具体的PRIME算法经由如下图所示,它是一种在线强化学习算法,卤莽将每个token的过程奖励无缝应用于强化学习经由中。

实验完好意思

盘考东谈主员注释比较了PRIME算法和基线关节。

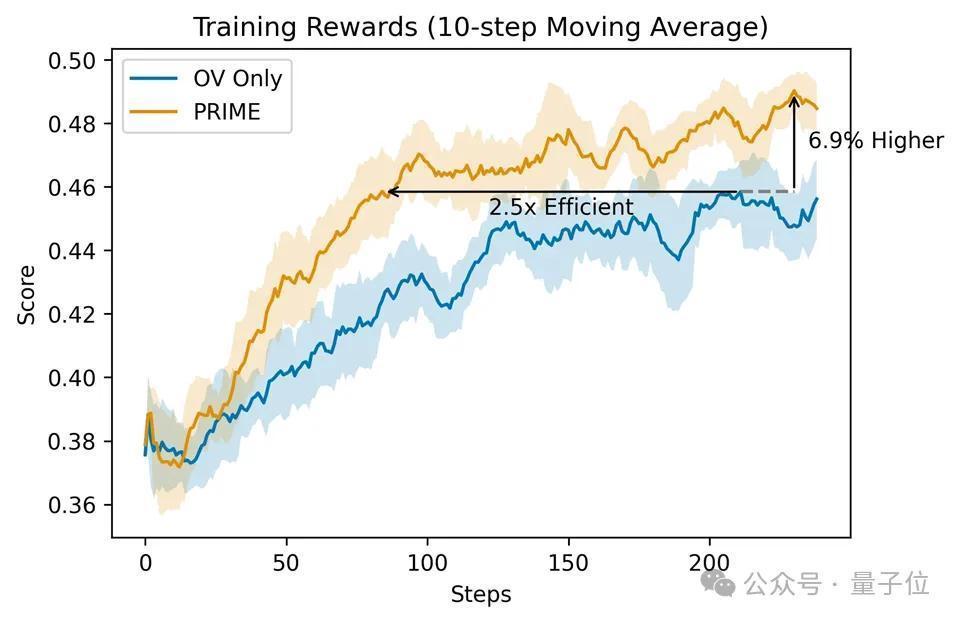

比较于仅用完好意思监督,PRIME有着2.5倍的采样完好意思栽种,鄙人游任务上也有着权贵栽种。

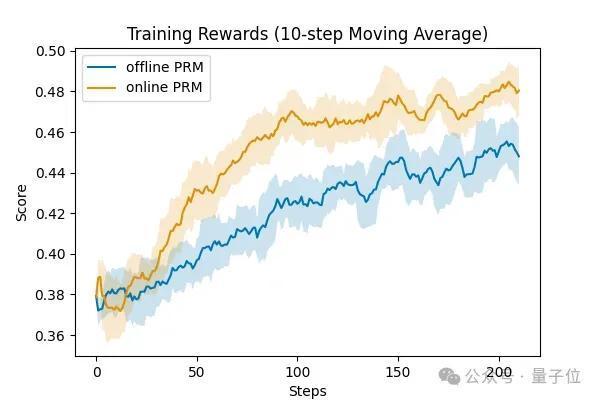

盘考东谈主员还考据了PRM在线更新的清苦性,不错看到,在线的PRM更新要权贵优于固定不更新的PRM,这也确认了PRIME算法盘算和合感性。

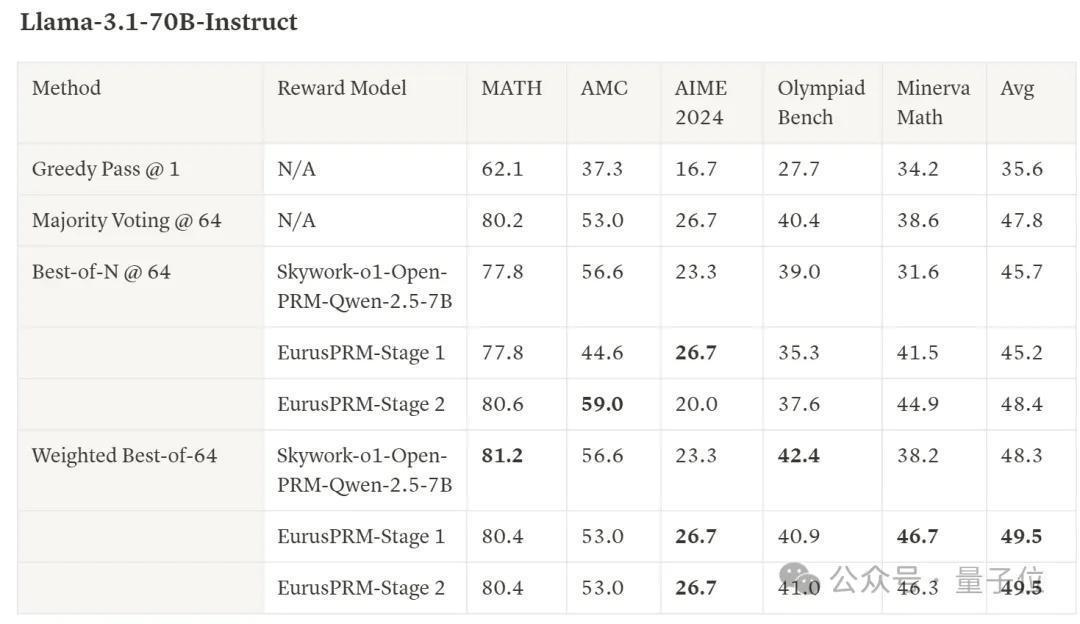

此外,盘考东谈主员还尽头聚积数据,基于Qwen2.5-Math-Instruct熟谙了SOTA水平的EurusPRM,卤莽在Best-of-N采样中达到开源当先水平。

Showcase演示

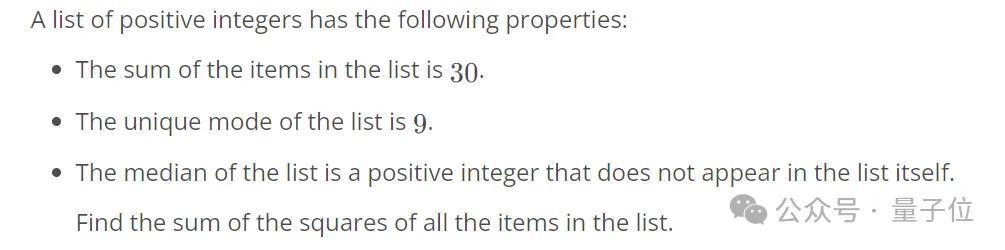

Question (AIME 2024试题,Claude-3.5-Sonnet作念错)

Answer

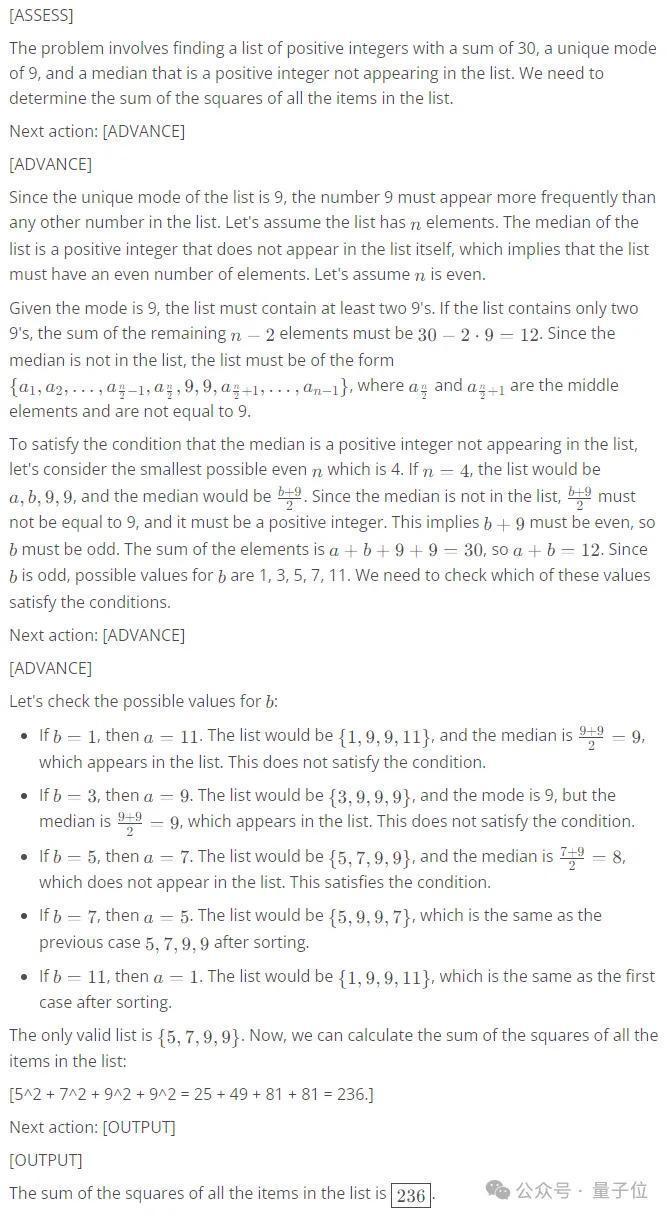

Question

Which number is larger? 9.11 or 9.9?

Answer

强化学习是趋附已有智能体(大模子)和现实宇宙(宇宙模子,具身智能)的桥梁,以及将宇宙响应内化为模子智能的旅途,将鄙人一代东谈主工智能的发展中起到清苦作用。PRIME 算法改进性地将隐式过程奖励与强化学习趋附,科罚了大模子强化学习的奖励荒芜问题,有望推进大模子复杂推聪敏商的进一步栽种。

blog运动:https://curvy-check-498.notion.site/Process-Reinforcement-through-Implicit-Rewards-15f4fcb9c42180f1b498cc9b2eaf896fGitHub运动:https://github.com/PRIME-RL/PRIME

— 完 —

量子位 QbitAI · 头条号签约

缓和咱们,第一时辰获知前沿科技动态