Llama版o1来了,来自上海AI Lab,强化学习代码已开源

梦晨 发自 凹非寺

量子位 | 公众号 QbitAI复刻OpenAI o1推理大模子,开源界传来最新推崇:

LLaMA版o1格局刚刚发布,来自上海AI Lab团队。

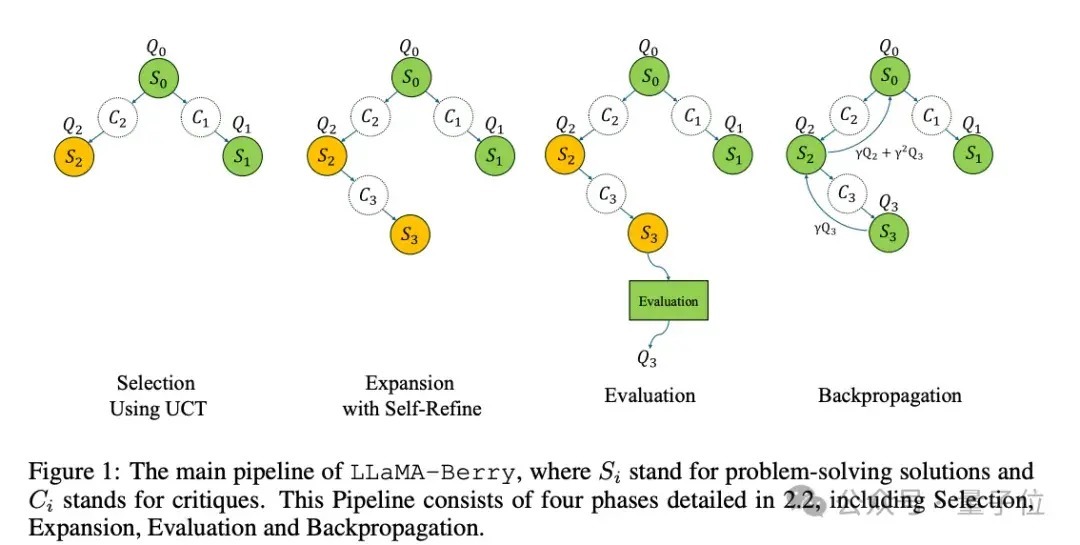

简介中明确:使用了蒙特卡洛树搜索,Self-Play强化学习,PPO,以及AlphaGo Zero的双重政策范式(先验政策+价值评估)。

在2024年6月,o1发布之前,团队就驱动探索蒙特卡洛树搜索提遍及模子数学智力,积贮了一些温和。

此次最新开源代码,也在竖立者社区引起热议。

OpenAI o1系列发布后,团队驱动升级算法,专注于数学奥赛问题,手脚OpenAI草莓项筹画开源版块。

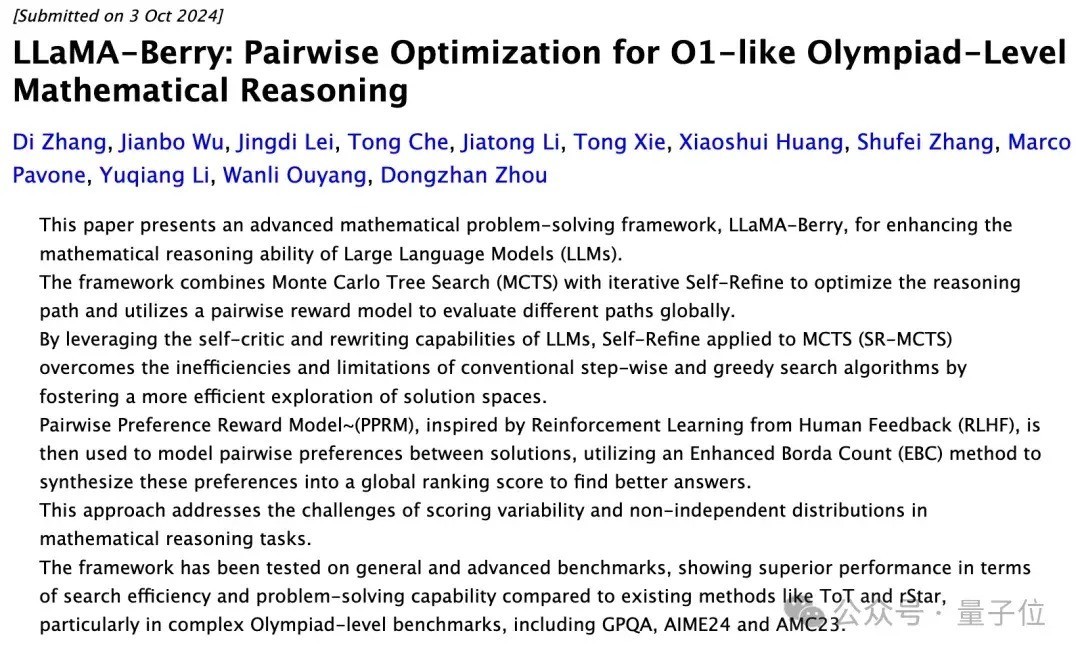

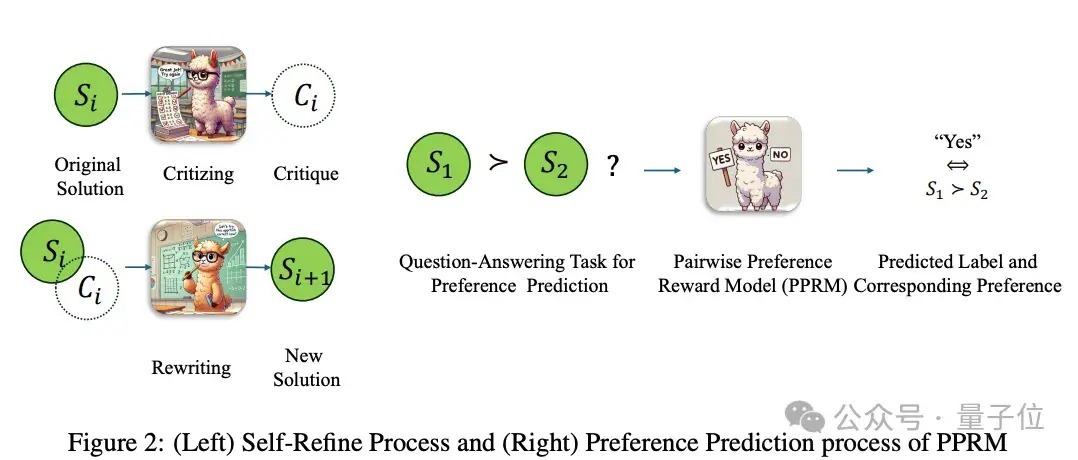

10月初,团队上传新论文,使用成对优化(不径直给出敷裕分数,而是比拟两个谜底的相对优劣)莳植Llama模子数学奥赛智力。

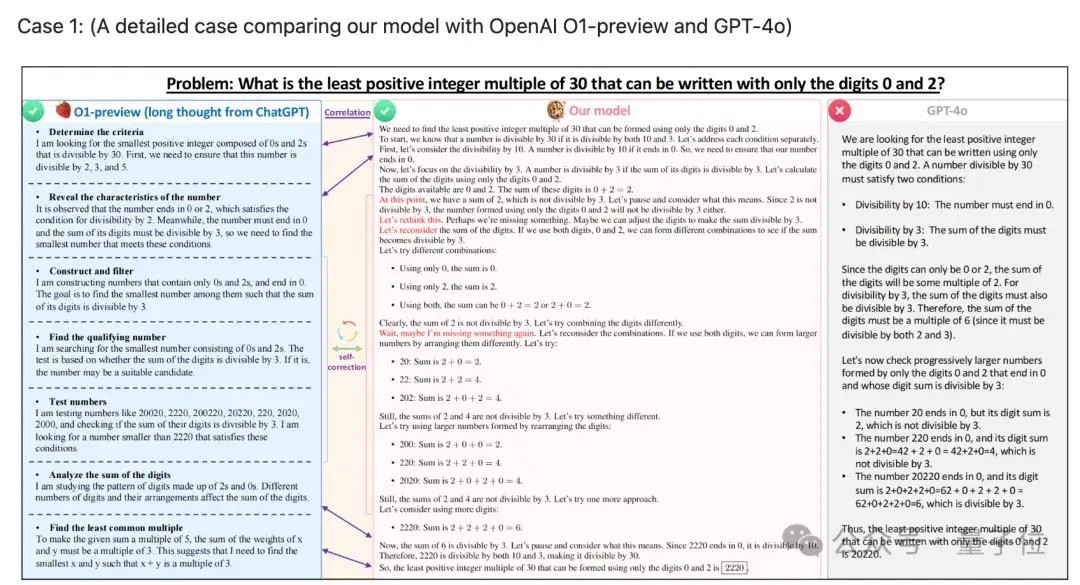

在最难的AIME2024基准测试30谈题中,原版LLaMA-3.1-8B-Instruct作念对2谈,优化后作念对8谈,特出了除o1-preview和o1-mini以外的其他交易闭源决策。

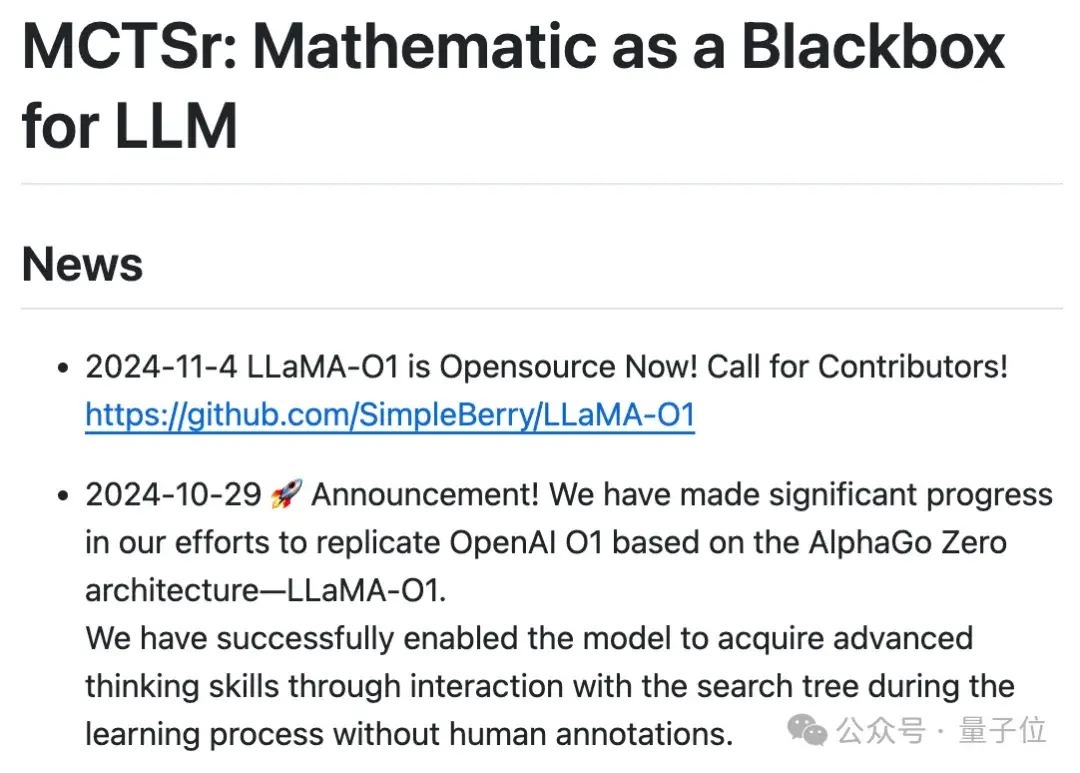

10月底,团队晓喻在基于AlphaGo Zero架构复刻OpenAI o1的死力中取得了关键推崇:

已得手使模子在学习历程中通过与搜索树交互得到高档念念维智力,无需东谈主工标注。

不到一周时期,格局便开源了。

LLaMA版o1最新推崇

当今已开源执行包括:预测验数据集、 预测验模子、强化学习测验代码。

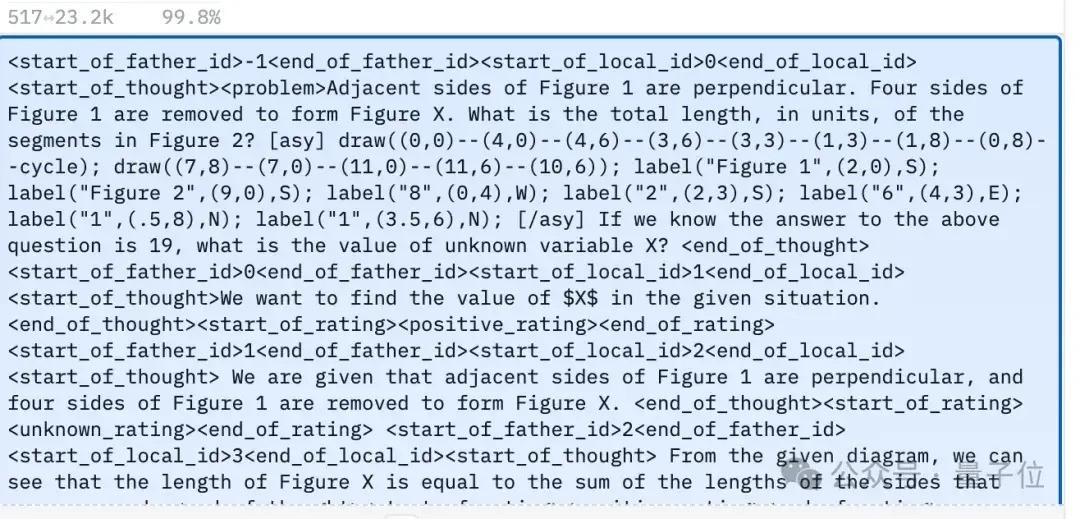

OpenLongCoT-Pretrain数据集,包含10万+条长念念维链数据。

每条数据包含一个竣工的数常识题推理历程,包含念念考执行和评分界限。

举例一个几何问题,包含了问题态状、图形坐标、缱绻历程和论断推导等竣工的推理链路,以及对各个推明智力的月旦和考据执行,对推理历程进行评价和教诲。

在此数据集不时预测验后,模子可读取和输出访佛o1的长念念维链历程。

预测验代码尚未发布,当今保举使用LLaMaFactory代替。

有真谛的是诚然格局名为LLaMA-O1,但当今官方给的预测验模子基于谷歌Gemma 2。

当今在预测验模子基础上,不错不时进行强化学习测验,从代码中不错看出测验历程如下:

使用蒙特卡洛树搜索进行自我对弈(self-play)以生成劝诫将劝诫存储在优先劝诫回放缓冲区中从缓冲区采样批次数据进行测验更新模子参数和劝诫优先级论文中也给出了测验历程的图示。

同期测验代码中使用了以下要道时代点:

使用LoRA进行参数高效微调使用PPO算法手脚政策优化法子兑现了GAE(Generalized Advantage Estimation)算法用于缱绻上风函数使用优先劝诫回放莳植测验成果临了,LLaMA-O1代码发布在名为SimpleBerry的GitHub账号下,并莫得出奇简介,还比拟奥密。

其他与SimpleBerry相关的账号和官网中,只可看出性质是一个征询实验室,也并未知道更多征询处所信息。

其他o1复刻格局推崇

除LLaMA-O1以外,另一个公开推崇的o1复刻格局O1-Journey来自上交大团队。

团队在十月初发布了第一份推崇解说,其中先容了翻新Journey Learning范式,以选取一个得手将搜索和学习整合到数学推理中的模子。

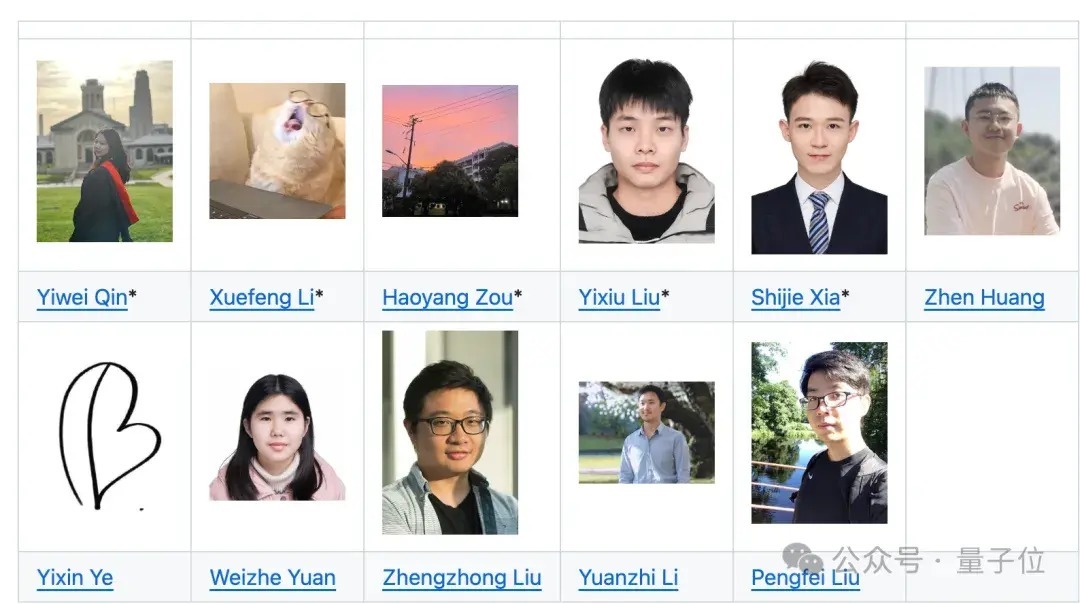

O1-Journey中枢竖立团队主要由上交大大三、大四本科生,以及上交大GAIR实验室(生成式东谈主工智能征询实验室)的一年齿博士生构成。

教诲老师包括上交大副陶冶刘鹏飞,姚班学友、斯隆奖得主李远志等。

LLaMA-O1:

https://github.com/SimpleBerry/LLaMA-O1关连论文:https://arxiv.org/abs/2406.07394https://arxiv.org/abs/2410.02884O1-Journey:

https://github.com/GAIR-NLP/O1-Journey/— 完 —

量子位 QbitAI · 头条号签约

温和咱们,第一时期获知前沿科技动态