事件相机+AI视频生成入选ICIP,无需历练杀青可控视频生成|港大

CUBE团队 投稿

量子位 | 公众号 QbitAI

在这个信息爆炸的期间,怎样让AI生成的视频更具创意,又相宜特定需求?

来自香港大学的最新参议《基于事件、无需历练的可控视频生成框架 CUBE》带来一个全新的科罚决策。

这一框架运用了事件相机捕捉动态边际的才智,将AI生成的视频带入了一个新的维度,精确又高效。论文原标题是“Controllable Unsupervised Event-based Video Generation”,

发表于图像处理嘉会ICIP并被选为Oral(理论评释),并受邀在WACV workshop演讲。

什么是事件相机?

在长远了解CUBE框架之前,先来刚劲一下事件相机。

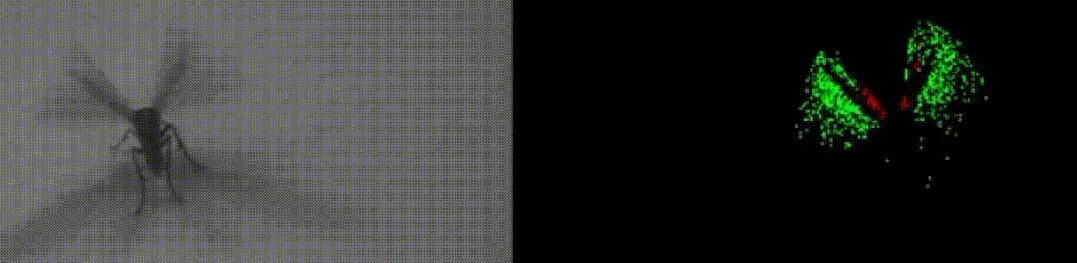

不同于传统相机的定时捕捉,事件相机师法生物的视觉系统,只捕捉像素点亮度变化的“事件”,就像是只纪录画面的精华部分。

这么不仅不错有用减少冗尾数据,还不错权贵缩小耗能。

尤其是在高速动态或后光变化大的场景下,事件相机比传统相机更有上风。而这些独到的“事件数据”恰是CUBE框架的中枢。

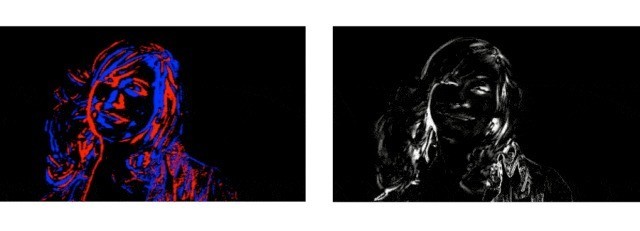

△左:泛泛相机拍的;右:事件相机拍的

肤浅说,事件相机和泛泛相机不同,捕捉的是物体边际的动态细节,就像你脑中一闪而过的灵感,检朴了无数带宽还能省电。

CUBE框架聚拢了这些“袒露”的边际数据和翰墨样式,无需历练成能合成相宜需求的视频!这不仅能让你生成的场景更“合胃口”,还能让视频质料、时刻一致性和文本匹配度齐蹭蹭高涨。

为什么要用CUBE?其他要津或是需要无数历练数据,或是生收遵守欠佳。CUBE框架不仅科罚了这些问题,还在多名地点上涌现出色。

不管是视觉遵守、文本匹配度依然帧间一致性,CUBE齐涌现优异。

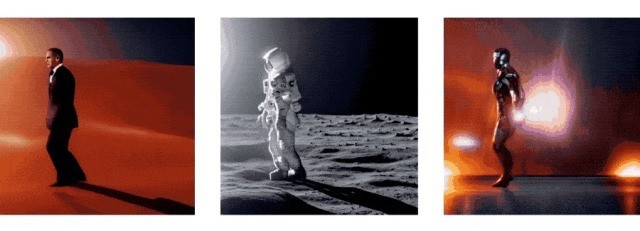

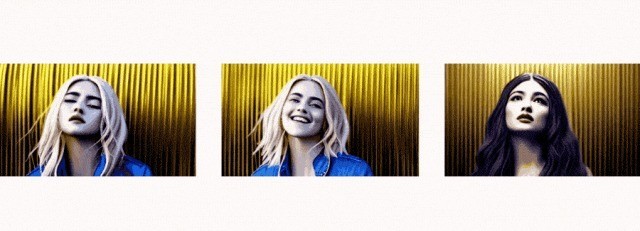

不错这么思:CUBE就像给事件相机配上了智能“滤镜”,让生成的视频不仅天真还相宜样式,比如让铁东说念主也能在马路上跳起月球舞步!

CUBE框架是怎样责任的?CUBE的全称是“Controllable, Unsupervised, Based on Events”,直译过来便是“可控的、无需历练的、基于事件的”视频生成框架。

它通过提真金不怕火事件中的边际信息,再聚拢用户提供的翰墨样式生成视频。在要津上,CUBE主要依赖扩散模子生成期间。

扩散模子通过向图像添加快即噪声并迟缓复原本生成图片,但团队进一步优化了这个进程,能让它把柄“事件”提供的边际数据生成视频。

CUBE的中枢要津1. 边际提真金不怕火:事件流纪录了物体畅通的轨迹,而CUBE的重要任务便是将这些事件调养成边际信息。团队野心了一个边际提真金不怕火模块,把事件数据分红多个时刻段,提真金不怕火出弊端的空间位置,从而酿成精确的边际图。这些边际图不仅保留了畅通物体的空洞,还能让视频生成更流通。

2. 视频生成:有了边际数据之后,CUBE聚拢了翰墨样式生成视频。通过扩散模子的迟缓复原进程,不错生成多个与样式相匹配的图像帧,并用插帧期间让视频愈加平滑一致。这个进程不需要无数的历练数据,因为CUBE径直调用了预历练的扩散模子来杀青高质料生成。

3. 适度性与一致性:继承了ControlVideo框架,这一框架具有优秀的可控性,通过翰墨样式来适度生成的视频施行,使每帧的生成齐相宜特定的条件。ControlVideo和CUBE的组合科罚了传统要津中视频生成一致性不及的问题,让施行新天真、更贴合样式。

CUBE的性能涌现

在实验中,CUBE的涌现远超现存要津。在视频质料、文本匹配度和时刻一致性等多个地点上,CUBE齐获取了优异的收货。

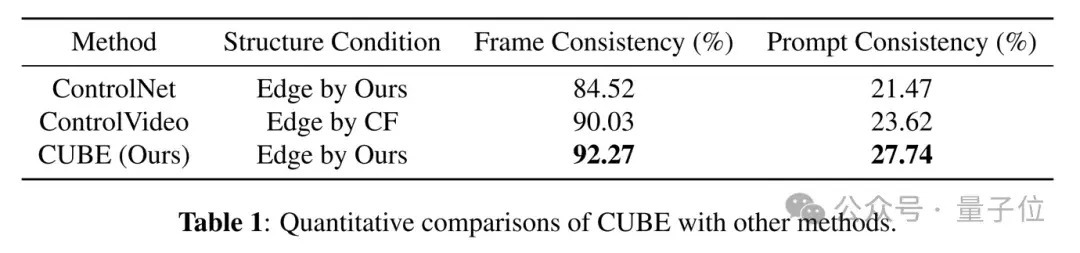

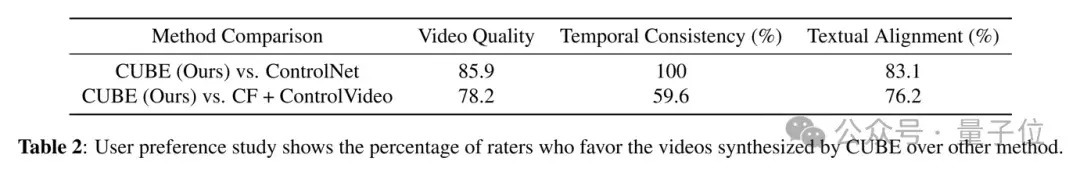

定量实验骄贵,CUBE生成的帧间一致性和文本匹配度齐比ControlNet、ControlVideo等要津更优。此外,团队还作念了用户偏好测试,拆伙骄贵参与者广博更可爱CUBE生成的视频。

改日算计

固然,CUBE还有擢升的空间。改日团队但愿将边际信息和纹理信息聚拢,使视频更具细节和确切感,同期探索更多界限适用性,以至将其应用在及时场景中。这一期间不仅允洽电影、动画生成等界限,还不错用于自动驾驶、监控等需要快速识别动态环境的场景。

CUBE不仅是一项期间,更是一次在事件相机与AI生成视频界限的新探索。

如若你也对AI生成视频感兴致,可进一步参考完好论文和开源代码。

论文地址:

https://ieeexplore.ieee.org/abstract/document/10647468代码已开源:https://github.com/IndigoPurple/cube— 完 —

量子位 QbitAI · 头条号签约

温雅咱们,第一时刻获知前沿科技动态